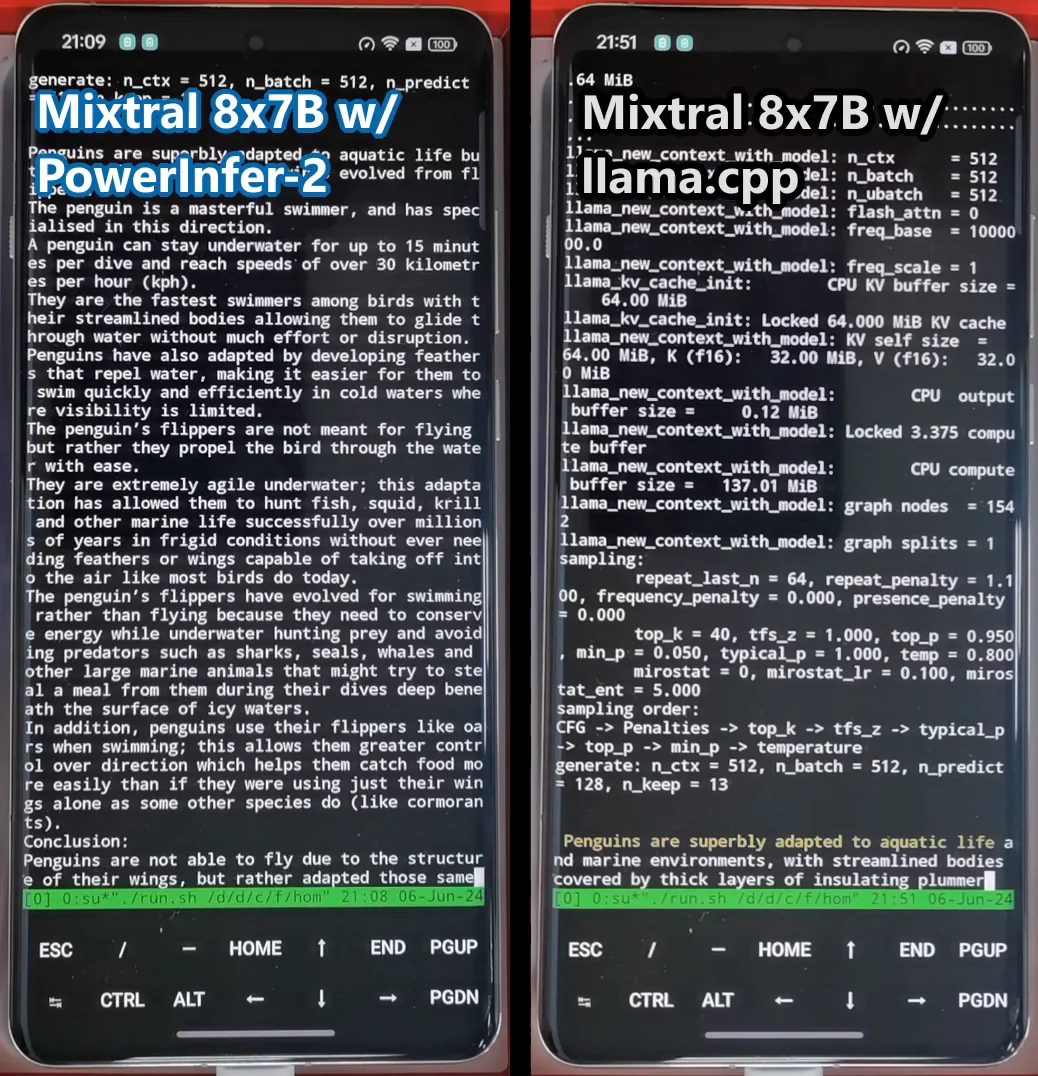

𝐏𝐨𝐰𝐞𝐫𝐈𝐧𝐟𝐞𝐫-𝟐 è un innovativo framework di inferenza ottimizzato per smartphone. È stato progettato per supportare modelli di grandi dimensioni come il 𝐌𝐢𝐱𝐭𝐫𝐚𝐥 𝟒𝟕𝐁 𝐌𝐨𝐄, raggiungendo velocità di inferenza straordinarie di 11,68 token al secondo, fino a 22 volte più veloce rispetto ai framework attuali. Anche con modelli più piccoli come quelli da 7 miliardi di parametri, PowerInfer-2 mantiene velocità di punta scaricando solo il 50% dei parametri sul telefono.

📌 Caratteristiche Principali:

𝐎𝐭𝐭𝐢𝐦𝐢𝐳𝐳𝐚𝐳𝐢𝐨𝐧𝐞 𝐇𝐚𝐫𝐝𝐰𝐚𝐫𝐞: sfrutta al meglio le diverse componenti hardware dello smartphone per calcoli più efficienti.

𝐏𝐢𝐩𝐞𝐥𝐢𝐧𝐞 𝐀𝐯𝐚𝐧𝐳𝐚𝐭𝐚: utilizza tecniche che permettono di sovrapporre il caricamento e il calcolo dei dati per massimizzare la velocità e l’efficienza.

𝐔𝐬𝐨 𝐢𝐧𝐭𝐞𝐥𝐥𝐢𝐠𝐞𝐧𝐭𝐞 𝐝𝐞𝐥𝐥𝐚 𝐦𝐞𝐦𝐨𝐫𝐢𝐚: processa solo i dati necessari per ogni iterazione, riducendo l’uso della memoria e migliorando le prestazioni.

𝐀𝐝𝐚𝐭𝐭𝐚𝐛𝐢𝐥𝐢𝐭𝐚̀: modifica le strategie di calcolo a seconda della fase dell’inferenza, ottimizzando l’uso delle risorse disponibili.

𝐂𝐚𝐜𝐡𝐞 𝐞𝐟𝐟𝐢𝐜𝐢𝐞𝐧𝐭𝐞: implementa tecniche di 𝒄𝒂𝒄𝒉𝒊𝒏𝒈 specifiche per mantenere i dati più utilizzati prontamente disponibili, riducendo i tempi di attesa.

𝐏𝐢𝐚𝐧𝐢𝐟𝐢𝐜𝐚𝐳𝐢𝐨𝐧𝐞 𝐨𝐭𝐭𝐢𝐦𝐚𝐥𝐞: analizza il modello, l’hardware e le esigenze dell’utente per creare un piano di esecuzione che garantisca le migliori prestazioni possibili.

🚀 Nuovi Modelli:

PowerInfer-2 introduce i modelli T𝐓𝐮𝐫𝐛𝐨𝐒𝐩𝐚𝐫𝐬𝐞-𝐌𝐢𝐬𝐭𝐫𝐚𝐥-𝟕𝐁 𝐞 𝐓𝐮𝐫𝐛𝐨𝐒𝐩𝐚𝐫𝐬𝐞-𝐌𝐢𝐱𝐭𝐫𝐚𝐥-𝟒𝟕𝐁, versioni ottimizzate dei modelli Mistral e Mixtral. Questi modelli sono stati addestrati con 150 miliardi di token a un costo di soli 0,1 milioni di dollari, e sono ora disponibili su Hugging Face.

📊 Valutazione delle Prestazioni:

PowerInfer-2 è stato valutato su due smartphone, dimostrando una velocità di inferenza fino a 𝟐𝟗,𝟐 𝐯𝐨𝐥𝐭𝐞 𝐬𝐮𝐩𝐞𝐫𝐢𝐨𝐫𝐞 𝐫𝐢𝐬𝐩𝐞𝐭𝐭𝐨 𝐚𝐢 𝐟𝐫𝐚𝐦𝐞𝐰𝐨𝐫𝐤 𝐚𝐭𝐭𝐮𝐚𝐥𝐢. È il primo sistema a supportare il modello TurboSparse-Mixtral-47B con una velocità di generazione di 11,68 token al secondo su uno smartphone.

💡L’introduzione di PowerInfer-2 può rappresentare 𝐮𝐧 𝐩𝐚𝐬𝐬𝐨 𝐢𝐦𝐩𝐨𝐫𝐭𝐚𝐧𝐭𝐞 𝐧𝐞𝐥𝐥𝐨 𝐬𝐯𝐢𝐥𝐮𝐩𝐩𝐨 𝐝𝐞𝐥𝐥’𝐀𝐈 𝐬𝐮 𝐝𝐢𝐬𝐩𝐨𝐬𝐢𝐭𝐢𝐯𝐢 𝐦𝐨𝐛𝐢𝐥𝐢. Questa innovazione consente l’inferenza rapida di modelli di linguaggio di grandi dimensioni direttamente su smartphone, aprendo la strada a nuove applicazioni e miglioramenti nell’efficienza e nella privacy dei dati. PowerInfer-2 sarà reso disponibile alla in modalità open-source.

📎 https://powerinfer.ai/v2/

Comments are closed